L’étude des territoires, qu’ils soient urbains ou ruraux, s’appuie de plus en plus sur une cartographie précise, à travers des programmes nationaux d’acquisition de données LiDAR d’une densité de 15 points/m² (LiDAR HD de l’IGN, swissSURFACE3D de swissTOPO). GEOFIT et SINTEGRA réalisent l’acquisition et la classification de ces nuages de points aériens.

De nombreuses solutions de classification existent aujourd’hui, mais l’un des principaux défis est d’assurer une production industrielle, pour atteindre le meilleur rapport entre efficacité et précision. GEOFIT a ainsi constitué une équipe spécialisée pour intégrer de nouvelles méthodes de classification par Deep Learning.

Des données de plus en plus volumineuses

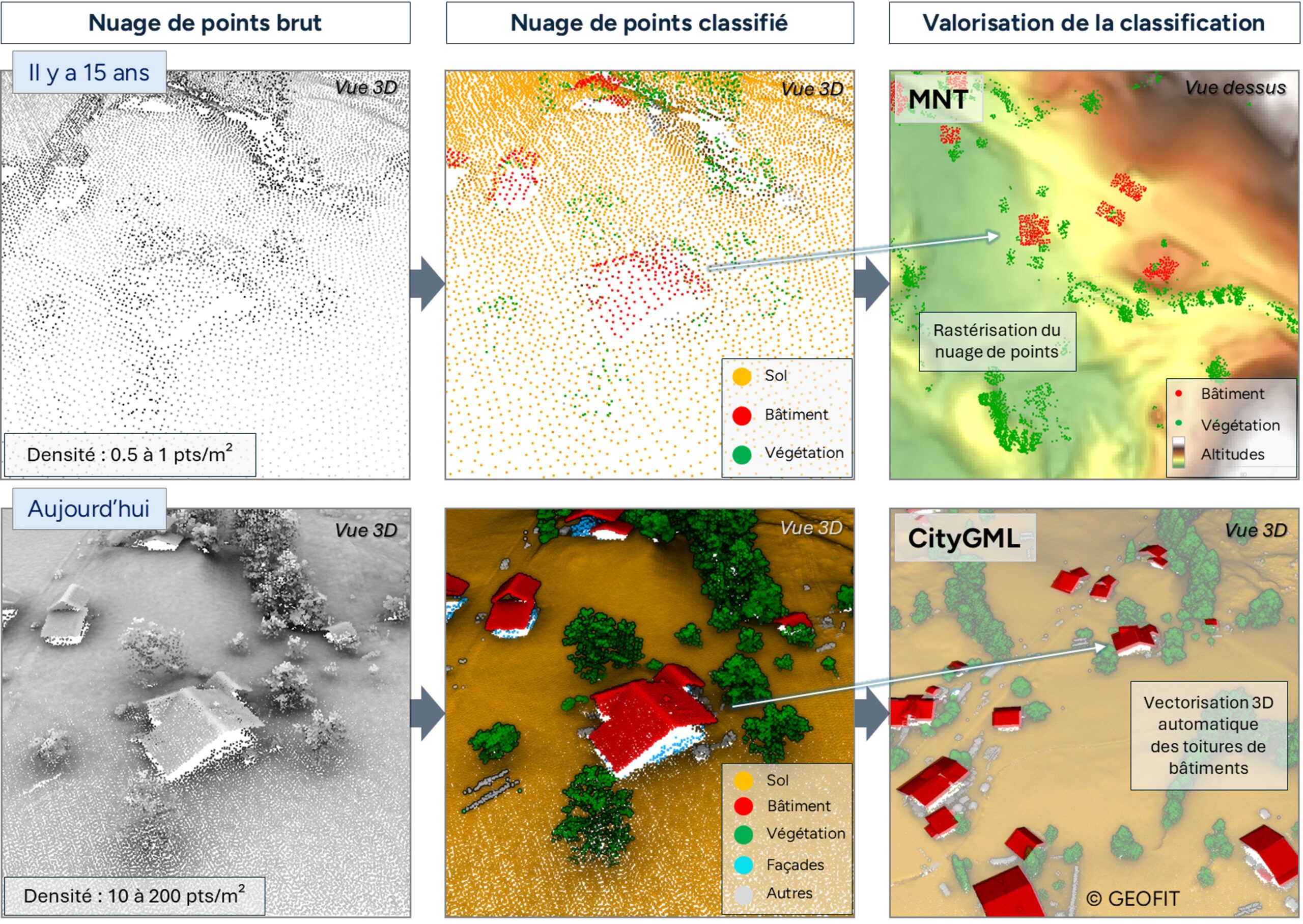

La classification des nuages de points, ou segmentation sémantique, attribue à chaque point une classe comme « bâtiment », « végétation », ou « sol ».

Les premières techniques s’appuyaient sur des acquisitions LiDAR de faible densité (~1 pt/m²), principalement utilisées pour la segmentation du sol et du sursol, en vue de créer des « Modèles Numériques de Terrain » (MNT). Ces méthodes, comme celles utilisées dans TerraScan©, appliquent des filtres successifs aux caractéristiques des nuages de points (planarité, intensité) pour distinguer les différentes classes (figure 1).

Figure 1 : Comparaison des classifications et des valorisations sur un nuage de points acquis il y a 15 ans (exemple de production d’un MNT) et aujourd’hui (vectorisation 3D des toitures (format CityGML)).

Aujourd’hui, avec des densités allant de 15 pts/m² pour le LiDAR HD à plus de 200 pts/m² pour certaines applications, la richesse des données permet de capturer les objets en détail et d’envisager des représentations 3D précises (ex : CityGML) (figure 1). En raison de cette quantité massive de données, le processus de classification est aujourd’hui coûteux en ressources.

Des méthodes de pré-classification automatique ont émergé pour réduire le coût et le temps de classification. L’avancée des technologies de l’Intelligence Artificielle (IA), notamment le Machine Learning (ML) et le Deep Learning (DL), a permis de développer des modèles robustes pour des prédictions automatiques.

La classification par Deep Learning

Les méthodes basées sur le Deep Learning nécessitent des données déjà annotées pour l’apprentissage supervisé. Un grand jeu de données varié est crucial pour améliorer la robustesse et la généralisation du modèle. Il s’agit donc d’annoter des bâtiments, de la végétation ou du sol dans des environnements côtiers, montagneux ou totalement urbains.

À partir de ces données, un modèle de réseau de neurones va s’entraîner à prédire une classe en évaluant sa performance avec la “vérité terrain” (des échantillons des données annotées). En répétant cette tâche des millions de fois, il peut généraliser la prédiction d’un poteau électrique quel que soit sa taille, sa forme ou son environnement. La méthode d’apprentissage, via l’architecture du modèle Deep Learning, doit donc être adaptée à la topologie d’un nuage de points LiDAR.

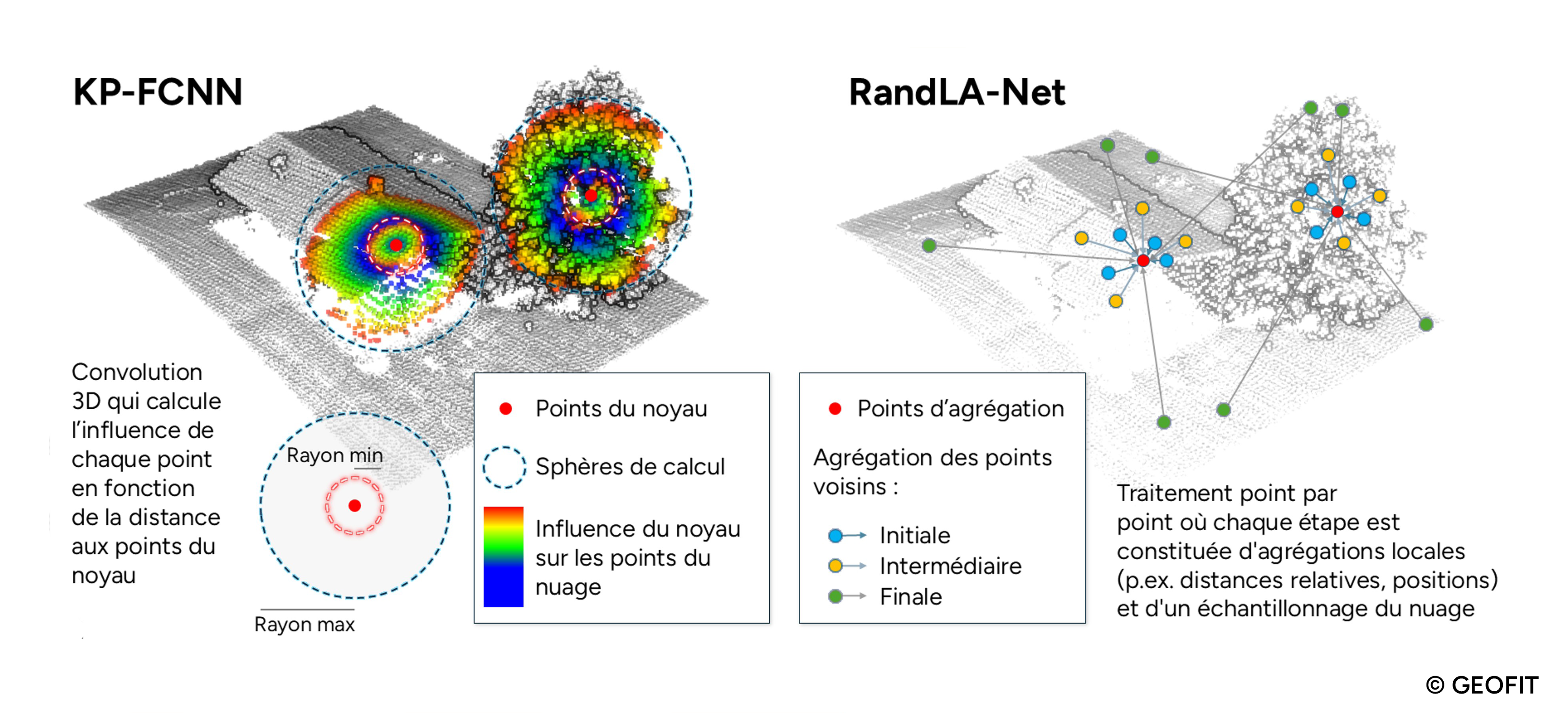

Les architectures de Deep Learning sur nuage de points

Les architectures comme KP-FCNN (“Kernel Point Fully Convolutional Neural Networks”) [1] utilisent des noyaux de points pour les convolutions en 3D. RandLA-Net [2] agrège les informations géométriques locales en utilisant des MultiLayer Perceptron (MLP) et des blocs d’attention pour simplifier les calculs (figure 2). Ces méthodes permettent de capturer et d’agréger les informations locales pour une segmentation sémantique précise.

Figure 2. Méthodes de classification de nuage de points par Deep Learning. A gauche l’approche de KP-FCNN se basant sur des sphères d’influence et à droite RandLA-Net qui se base sur un échantillonnage du nuage.

Mise en production industrielle

Le modèle d’apprentissage est ensuite perfectionné, après de nombreuses heures d’entraînement et de tests. Cette phase est réalisée grâce à des outils de MLOps (“Machine Learning Operations“) qui permettent de comparer et d’analyser les progrès d’apprentissage des modèles. Une fois que le modèle atteint de bonnes performances de prédictions, nous l’exploitons pour réaliser la production de classification : on parle d’inférence. La phase d’inférence consiste donc à appliquer le modèle entraîné pour effectuer des prédictions sur de nouvelles données.

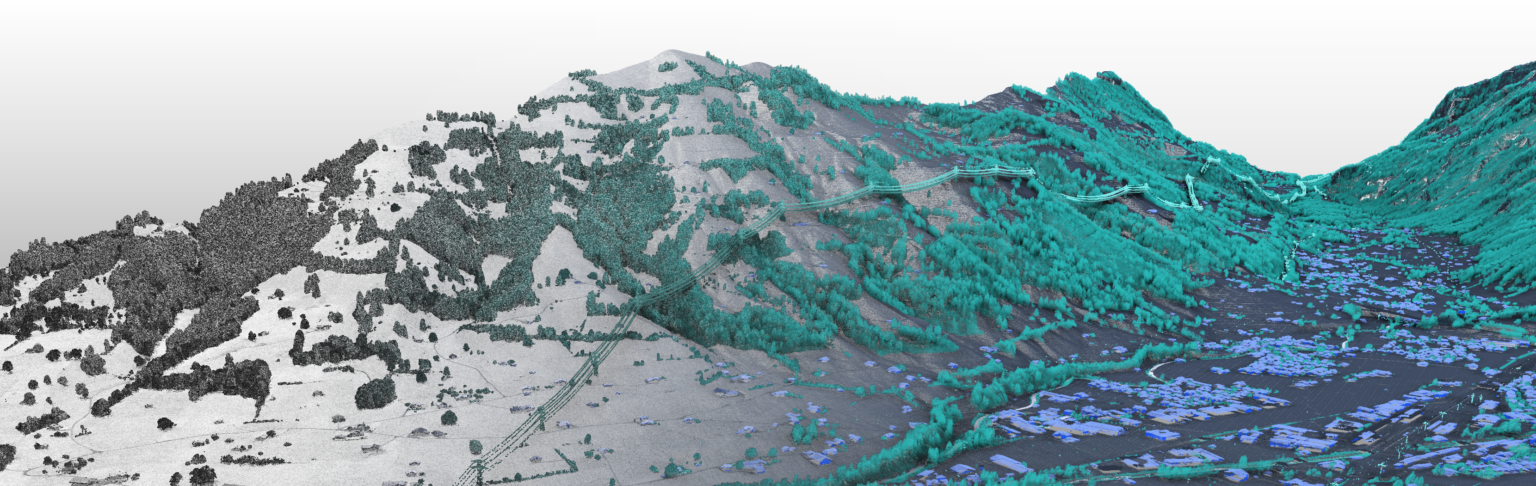

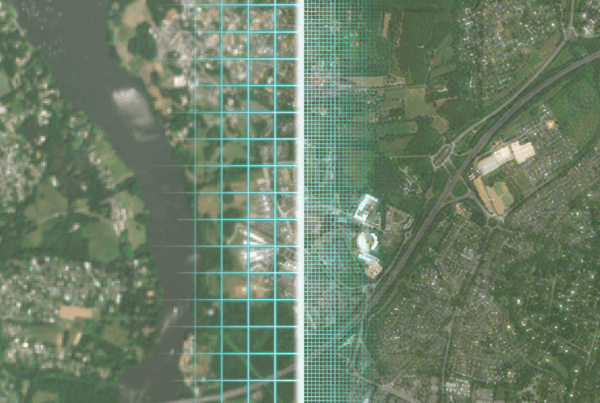

L’utilisation d’un modèle de Deep Learning en open-source est accessible à tous. L’un de nos défis réside dans le fait de maîtriser et d’adapter ces architectures, afin d’assurer une robustesse conforme aux exigences industrielles. Cela inclut l’adaptation aux diverses conditions d’acquisition, aux types d’objets et aux variétés topographiques spécifiques (figure 3).

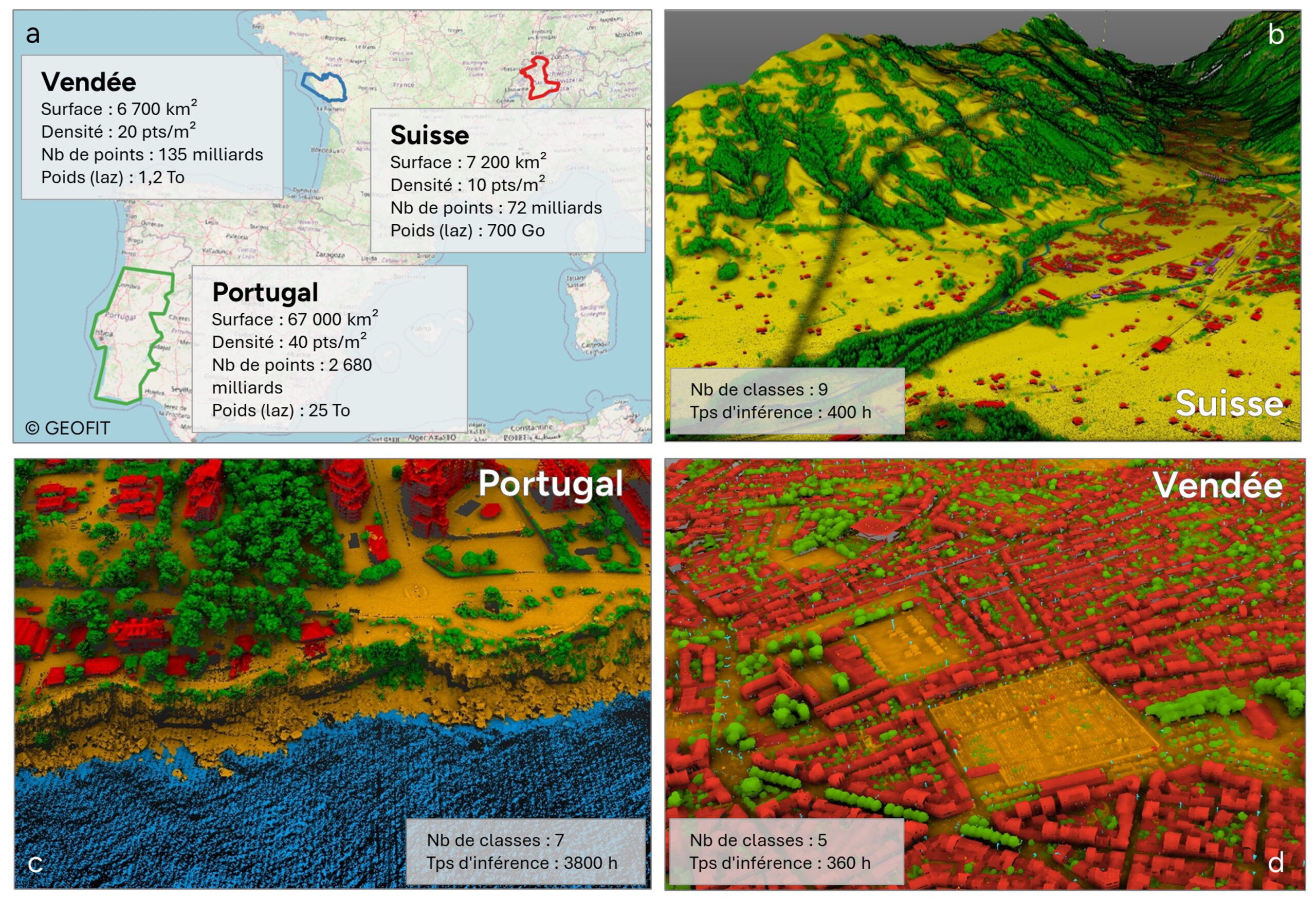

Figure 3 : a. Surfaces de données acquises et classifiées sur les zones de la Vendée, la Suisse et le Portugal ; b. Illustration de classification en zone de montagne ; c. en zone urbaine et d. en zone côtière.

La classification d’un nuage de points n’est que la première étape de son traitement et sa valorisation. Lorsqu’il s’agit de cartographier un territoire, l’un des défis est d’exploiter chaque classe du nuage de points pour en produire une donnée raster ou vectorielle précise et exploitable. Les cas d’usages sont multiples :

- Optimisation des réseaux de distribution ;

- Auscultation des lignes haute tension ;

- Création d’un cadastre solaire ;

- Étude de zones ombragées en ville ;

- Création de jumeaux numériques au format CityGML ;

- Génération de plan PCRS.

Conclusions et perspectives

Ces avancées en Deep Learning ouvrent de nouvelles perspectives pour la classification des nuages de points, permettant une modélisation plus détaillée des objets. L’augmentation des volumes de données nécessite des méthodes d’automatisation pour tirer profit de ces données riches. Bien que coûteuses à mettre en place, ces méthodes offrent une généralisation à des environnements variés et une analyse fine des objets. Les perspectives incluent le développement de nouvelles méthodes comme les Transformers ou le Self Supervised Learning, mais qu’il faut adapter à la donnée « nuage de points ».

Pour approfondir le sujet, vous pouvez retrouver notre article complet dans le magazine XYZ n°180 :